Was ist ein Crawler: Wie die Datenspinnen das Internet optimieren

Crawler sind der Grund dafür, dass Suchmaschinen wie Google, Bing, Yahoo und DuckDuckGo immer aktuelle und neue Suchergebnisse liefern können. Wie Spinnen wandern die Bots durch das Netz, sammeln Informationen und legen diese in Indexen an. Doch wo kommen Webcrawler noch zum Einsatz und welche verschiedenen Crawler gibt es im World Wide Web?

- Kostengünstig: Google-Ranking verbessern ohne teure Agentur

- Effizient: Rezensionen beantworten, Posts für Social Media erstellen

- Einfach: Keine SEO- oder Marketing-Kenntnisse nötig

Was ist ein Crawler?

Crawler sind Bots, die das Internet nach Daten durchsuchen. Sie analysieren Inhalte und legen Informationen in Datenbanken und Indexen an, um die Leistung von Suchmaschinen zu verbessern. Darüber hinaus sammeln sie für Marketing-Zwecke Kontakt- und Profildaten.

Da Crawler-Bots sich auf der Suche nach Informationen so sicher durch das Netz mit all seinen Verzweigungen bewegen wie Spinnen, sind sie auch als Spider Bots bekannt. Andere Bezeichnungen sind Search Bots und Webcrawler. Der erste Crawler trug den Namen World Wide Web Wanderer (kurz: WWW Wanderer) und basierte auf der Programmiersprache PERL. Ab 1993 maß der WWW Wanderer das Wachstum des damals noch jungen Internets und legte die gesammelten Daten im ersten Internet-Index Wandex an.

Crawler sind vor allem für die Suchmaschinenoptimierung (SEO) von wesentlicher Bedeutung. So ist es für Unternehmen essenziell, sich mit den unterschiedlichen Arten und Funktionen der Webcrawler vertraut zu machen, um online SEO-optimierte Inhalte anbieten zu können.

Wie funktioniert ein Crawler?

Genau wie Social Bots und Chatbots setzen sich auch Crawler aus einem Code von Algorithmen und Skripten zusammen, der klare Aufgaben und Befehle erteilt. Der Crawler wiederholt die im Code festgelegten Funktionen selbstständig und kontinuierlich.

Crawler bewegen sich über Hyperlinks bereits vorhandener Websites durch das Web. Sie werten Keywords und Hashtags aus, indexieren die Inhalte und URLs jeder Website, kopieren Webpages und öffnen alle oder nur eine Auswahl der gefundenen URLs, um neue Websites zu analysieren. Zudem überprüfen Crawler die Aktualität von Links und HTML-Codes.

Über spezielle Webanalyse-Tools können Webcrawler Informationen wie Seitenaufrufe und Verlinkungen auswerten und im Sinne des Data Mining Daten sammeln oder (zum Beispiel für Vergleichsportale) gezielt vergleichen.

Immer häufiger nutzen Suchmaschinen und spezialisierte Crawler auch künstliche Intelligenz und Natural Language Processing (NLP), um Webinhalte nicht nur technisch, sondern auch inhaltlich besser zu verstehen. So können moderne Crawler beispielsweise semantische Zusammenhänge, Themenrelevanz oder Textqualität analysieren.

Welche Crawler-Arten gibt es?

Es gibt verschiedene Webcrawler, die sich in ihrem Fokus und in ihrer Reichweite unterscheiden.

Suchmaschinen-Crawler

Die älteste und häufigste Art von Webcrawlern sind die Searchbots von Google oder alternativen Suchmaschinen wie Yahoo, Bing oder DuckDuckGo. Sie sichten, sammeln und indexieren Web-Content und optimieren so die Reichweite und die Suchmaschinen-Datenbank. Die Namen der bekanntesten Webcrawler sind:

- GoogleBot (Google)

- Bingbot (Bing)

- DuckDuckBot (DuckDuckGo)

- Baiduspider (Baidu)

- Yandex Bot (Yandex)

- Sogou Spider (Sogou)

- Exabot (Exalead)

- GPTBot (OpenAI)

- ClaudeBot (Anthropic)

Personal-Website-Crawler

Diese kleinen Crawler sind in ihrer Funktion einfach gehalten und können von einzelnen Unternehmen genutzt werden, um spezifische Aufgaben zu erfüllen. So überwachen sie zum Beispiel die Häufigkeit bestimmter Suchbegriffe oder die Erreichbarkeit von bestimmten URLs.

Kommerzielle Website-Crawler

Kommerzielle Crawler sind komplexe Software-Lösungen von Firmen, die Webcrawler als käufliche Tools anbieten. Sie bieten mehr Leistungen und Funktionen und sparen einem Unternehmen Zeit und Kosten, die eine eigene Crawler-Entwicklung erfordern würde.

Cloud-Website-Crawler

Es gibt auch Website-Crawler, die Daten nicht auf lokalen Servern, sondern in einer Cloud speichern und die meist kommerziell als Service von Software-Firmen vertrieben werden. Durch die Unabhängigkeit von lokalen Computern lassen sich die Analysetools und Datenbanken mit entsprechendem Login-Zugang von jedem Gerät aus nutzen. Zudem lässt sich die Anwendbarkeit skalieren.

Desktop-Website-Crawler

Man kann auch kleine Webcrawler auf dem eigenen PC oder Laptop laufen lassen. Diese sehr begrenzt einsetzbaren, günstigen Crawler können meist nur kleine Mengen an Daten und Websites auswerten.

Mobile-Crawler

Mobile-Crawler analysieren Websites so, wie sie auf Smartphones und Tablets dargestellt werden. Seit der Umstellung auf Mobile-First-Indexierung durch Google sind sie entscheidend für die Suchmaschinenplatzierung. Sie können beispielsweise Probleme bei der Darstellung erkennen und entsprechend bewerten.

AI-Crawler

Bei AI-Crawlern handelt es sich um KI-basierte Webcrawler. Sie werden von Unternehmen eingesetzt, um Inhalte aus dem Web zu analysieren, zu bewerten oder für das Training großer Sprachmodelle (LLMs) zu verwenden. Anders als klassische Suchmaschinenbots indexieren sie Websites nicht nur, sondern verstehen die Inhalte auf einer semantischen Ebene, extrahieren Wissen und nutzen es zur Verbesserung von Modellen.

- Kampagnen-Steuerung durch unsere Experten

- Spart Zeit: Keine Einarbeitung erforderlich

- Spart Kosten: Höchste Effizienz durch Expertise

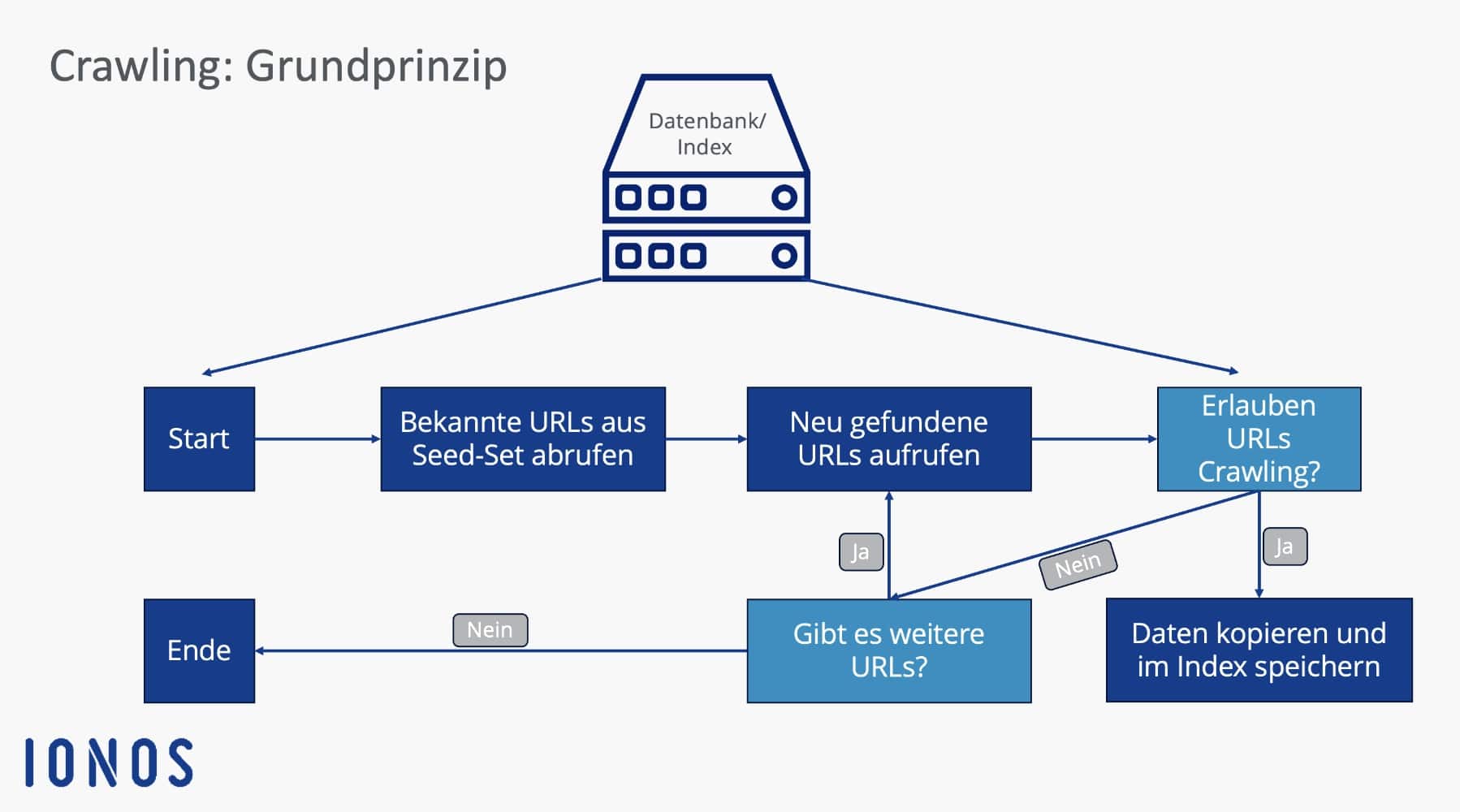

Wie gehen Crawler konkret vor?

Die konkrete Vorgehensweise eines Webcrawlers besteht aus mehreren Schritten:

- Crawl-Frontier: Suchmaschinen legen in einer Datenstruktur namens Crawl-Frontier fest, ob Crawler über bekannte, indexierte Websites und in Sitemaps angegebene Links neue URLs erforschen oder nur spezifische Websites und Inhalte crawlen sollen.

- Seed-Set: Crawler erhalten von der Suchmaschine oder dem Auftraggeber ein sogenanntes Seed-Set. Das Seed-Set ist eine Liste von bekannten oder zu erforschenden Web-Adressen und URLs. Das Set baut auf bisherigen Indexierungen, Datenbanken und Sitemaps auf. Crawler erforschen das Set, bis sie Schleifen oder tote Links erreichen.

- Index-Ergänzung: Durch die Seed-Analyse können Crawler neuen Webcontent auswerten und zum Index hinzufügen. Alten Content aktualisieren sie oder löschen URLs und Links aus dem Index, wenn diese nicht mehr existieren.

- Crawling-Frequenz: Obwohl Crawler ununterbrochen das Web erforschen, können Programmierer bestimmen, wie oft sie URLs besuchen und auswerten sollen. Dafür analysieren sie die Seiten-Performance, die Häufigkeit von Aktualisierungen und den Datenverkehr. Darauf aufbauend definieren die Programmierer die Crawl-Nachfrage.

- Indexierungsmanagement: Website-Administratoren können Crawler gezielt vom Besuch der eigenen Website ausschließen. Dies ist durch sogenannte robots.txt-Protokolle oder

nofollow-HTML-Tags möglich. Crawler erhalten beim Aufrufen einer URL dadurch Anweisungen, eine Website zu meiden oder nur eingeschränkt Daten auszuwerten.

Seit 2020 behandelt Google das nofollow-Attribut nicht mehr als strikte Anweisung, sondern nur noch als Hinweis zur Bewertung von Links. Das bedeutet, dass Google nofollow-Links unter Umständen trotzdem crawlen und indexieren kann. Für Website-Betreiberinnen und -Betreiber heißt das: Wenn Sie Inhalte wirklich vom Crawling ausschließen möchten, sollten Sie zusätzlich auf die robots.txt oder das noindex-Tag achten.

Welche Vorteile haben Crawler?

Kostengünstig und effektiv: Webcrawler übernehmen zeit- und kostenintensive Analyse-Aufgaben und können schneller, günstiger und umfassender Web-Content scannen, analysieren und indexieren als Menschen.

Einfache Anwendung, große Reichweite: Webcrawler lassen sich schnell und einfach implementieren und garantieren umfassende und kontinuierliche Datensammlung und -analyse.

Verbesserung der Online-Reputation: Mit Crawlern lässt sich das eigene Online-Marketing durch die Ausweitung und Fokussierung des eigenen Kundenspektrums optimieren. Zudem können Crawler die Online-Reputation eines Unternehmens durch die Erfassung von Kommunikationsmustern in sozialen Medien verbessern.

Gezielte Werbung: Durch Data Mining und gezielte Werbung lassen sich spezifische Kundengruppen ansprechen. Websites mit hoher Crawling-Frequenz werden in Suchmaschinen höher gelistet und erhalten mehr Aufrufe.

Auswertung von Unternehmens- und Kundendaten: Unternehmen können durch Crawler online verfügbare Kunden- und Unternehmensdaten auswerten, analysieren und für das eigene Marketing und die Unternehmensstrategie nutzen.

SEO-Optimierung: Durch Auswertung von Suchbegriffen und Keywords lassen sich Fokus-Keywords definieren, die Konkurrenz eingrenzen und Seitenaufrufe erhöhen.

Weitere Anwendungsmöglichkeiten sind:

- kontinuierliche Überwachung von Systemen, um Schwachstellen zu finden

- Archivierung alter Websites

- Vergleich von aktualisierten Websites mit alten Versionen

- Aufspüren und Entfernen toter Links

- Untersuchung des Keyword-Suchvolumens

- Aufspüren von Schreibfehlern und anderen fehlerhaften Inhalten

Wie lässt sich die Crawling-Frequenz einer Website erhöhen?

Wenn Sie möchten, dass Ihre Website in Suchmaschinen möglichst weit oben steht und regelmäßig von Webcrawlern besucht wird, sollten Sie es den Bots so leicht wie möglich machen, Ihre Website zu finden. Wer eine hohe Crawling-Frequenz hat, erhält in Suchmaschinen eine höhere Priorität. Soll eine Website von Crawlern leichter gefunden werden, sind folgende Faktoren entscheidend:

- Die Website hat verschiedene weiterführende Links und ist auch auf anderen Websites verlinkt. So finden Crawler Ihre Website nicht nur über Links, sondern können die Website als weiterführenden Knoten und nicht nur als Einbahnstraße werten.

- Der Website-Content ist stets aktualisiert und aktuell gehalten. Dies betrifft Inhalte, Links und HTML-Code.

- Die Erreichbarkeit des Servers ist gewährleistet.

- Die Ladezeit der Website ist gut.

- Es gibt keine doppelten oder überflüssigen Links und Inhalte.

- Sitemap, robots.txt und http-Response-Header vermitteln dem Crawler bereits wichtige Informationen über die Website.

Webcrawler und Scraper: Was ist der Unterschied?

Obwohl man sie oft miteinander gleichsetzt, zählen Webcrawler und Scraper nicht zur gleichen Art von Bot. Während Webcrawler in erster Linie Web-Inhalte suchen, in Indexen anlegen und bewerten, haben Scraper vor allem die Aufgabe, durch Web Scraping Daten von Websites zu extrahieren.

Obwohl es zwischen einem Crawler und einem Scraper Überschneidungen gibt und auch Crawler oftmals Web-Scraping anwenden, indem sie Webinhalte kopieren und abspeichern, sind ihre Hauptfunktionen das Abrufen von URLs, die Analyse der Inhalte und die Erweiterung des Index um neue Links und URLs.

Scraper wiederum haben in erster Linie die Funktion, spezifische URLs zu besuchen, spezifische Daten der Websites zu entnehmen und diese in Datenbanken für späteren Gebrauch zu speichern.