Was ist Machine Learning?

Machine Learning ist ein Teilgebiet der künstlichen Intelligenz, bei dem Computermodelle aus Daten lernen, um ohne explizite Programmierung Vorhersagen oder Entscheidungen zu treffen. Es ist nicht nur interessant für die Wissenschaft und für IT-Unternehmen wie Google oder Microsoft. Auch die Welt des Onlinemarketings kann sich durch die Entwicklungen der künstlichen Intelligenz verändern.

Was ist Maschinelles Lernen?

Grundsätzlich funktionieren Maschinen, Computer, Programme nur so, wie man es zuvor festgelegt hat: „Wenn Fall A eintritt, dann machst du B.“ Unsere Erwartungshaltung an moderne Computersysteme wird aber immer höher und Programmierende können nicht alle denkbaren Fälle vorhersehen und dem Computer eine Lösung dafür diktieren. Deshalb ist es notwendig, dass die Software selbstständig Entscheidungen trifft und angemessen auf unbekannte Situationen reagiert. Dafür müssen aber Algorithmen vorhanden sein, die es dem Programm ermöglichen, zu lernen. Das bedeutet, dass es in einem ersten Schritt mit Daten gefüttert wird, um dann im zweiten Schritt Muster zu verstehen und Assoziationen zu treffen. Genau darum geht es beim Machine Learning.

Im Zusammenhang mit selbstlernenden Systemen tauchen immer wieder verwandte Begriffe auf, die man verstehen sollte, um auch ein besseres Verständnis von Machine Learning zu haben.

- 100 % DSGVO-konform und sicher in Deutschland gehostet

- Die leistungsstärksten KI-Modelle auf einer Plattform

- Kein Vendor Lock-in durch Open Source

Künstliche Intelligenz

Die Forschung rund um künstliche Intelligenz (KI) versucht, Maschinen zu erschaffen, die wie Menschen agieren können: Die Computer und Roboter sollen ihre Umgebung analysieren und dann die bestmögliche Entscheidung treffen. Sie sollen sich also – nach unseren Maßstäben – intelligent verhalten. Und darin besteht auch das Problem der Bezeichnung: Es ist noch nicht einmal sicher, nach welchen Kriterien wir unsere eigene Intelligenz zu beurteilen haben. Gegenwärtig kann KI – oder was als solche bezeichnet wird – gar nicht den ganzen Menschen (inklusive emotionaler Intelligenz) simulieren. Stattdessen werden Teilaspekte isoliert, um spezifische Aufgaben zu bewältigen. Dies wird gemeinhin als „schwache künstliche Intelligenz“ bezeichnet.

Seit 2022 haben Systeme mit generativer KI wie der KI-Assistent ChatGPT stark an Bedeutung gewonnen. Diese basieren auf Transformermodellen, die in der Lage sind, auf der Basis riesiger Datenmengen Texte, Bilder oder Code zu erzeugen. Dennoch handelt es sich weiterhin um spezialisierte Systeme, die keine echte Allgemeinintelligenz besitzen.

Neuronale Netze

Ein Zweig der Forschung zur künstlichen Intelligenz, die Neuroinformatik, versucht noch mehr, Computer nach dem Vorbild von Gehirnen zu gestalten. Sie betrachtet Nervensysteme abstrahiert – also befreit von ihren biologischen Eigenschaften und rein auf die Funktionsweise beschränkt. Bei künstlichen neuronalen Netzen handelt es sich in erster Linie nicht um eine tatsächliche Manifestierung, sondern um mathematische, abstrakte Verfahren. Es wird ein Netz aus Neuronen (mathematische Funktionen bzw. Algorithmen) gebildet, das wie ein menschliches Gehirn komplexe Aufgaben bewältigen kann. Die Verbindungen zwischen den Neuronen sind unterschiedlich stark und können sich an Probleme anpassen.

Die Weiterentwicklung neuronaler Netze hat zum Aufstieg des Deep Learning geführt. Hierbei handelt es sich um komplexe neuronale Netze mit vielen Schichten (Layern), die heute dominieren.

Big Data

Der Begriff „Big Data“ beschreibt im ersten Zugang lediglich, dass es sich um riesige Datenmengen handelt. Es gibt allerdings keinen definierten Punkt, ab wann man nicht mehr einfach von Data, sondern von Big Data spricht. Dass dieses Phänomen in den letzten Jahren auch in den Medien verstärkt Beachtung findet, liegt darin begründet, wo diese Daten herkommen: In vielen Fällen entsteht die Informationsflut aus Nutzerdaten (Interessen, Bewegungsprofile, Vitaldaten), die von Unternehmen wie Google, Amazon oder Facebook erhoben werden, um das Angebot genauer auf die Kundinnen und Kunden zuzuschneiden.

Derartige Datenmengen können von traditionellen Computersystemen nicht mehr befriedigend ausgewertet werden: Eine herkömmliche Software findet auch nur das, wonach User suchen. Deshalb braucht es hierfür selbstlernende Systeme, die zuvor unbekannte Zusammenhänge aufdecken können.

Data-Mining

Als Data-Mining bezeichnet man die Analyse von Big Data. Die Erfassung der Daten allein hat noch nicht besonders viel Wert. Den bekommen die Informationsberge erst dann, wenn man die relevanten Merkmale extrahiert und auswertet – ähnlich wie beim Goldschürfen. Zum maschinellen Lernen grenzt sich Data-Mining dadurch ab, dass es bei Ersterem vor allem um das Anwenden von erkannten Mustern geht und bei Letzterem darum, neue Muster zu finden. Zu den Methoden des Data-Mining gehören daher beispielsweise Clusteranalysen, Entscheidungsbäume, Regressionsverfahren und Assoziationsanalysen. Data-Mining ist heute oft Bestandteil von Business-Intelligence-Systemen oder dient der Predictive Analytics, um Kundenverhalten oder Markttrends vorherzusagen.

Machine-Learning-Methoden im Vergleich

Grundsätzlich unterscheiden Entwicklerinnen und Entwickler zwischen Supervised Learning, Unsupervised Learning und Deep Learning. Die dabei verwendeten Algorithmen sind sehr unterschiedlich.

Supervised Learning

Beim überwachten Lernen bzw. Supervised Learning wird das System mit Beispielen versorgt. Die Entwickelnden geben dabei an, welchen Wert die jeweilige Information erhält, also etwa, ob diese in Kategorie A oder B gehört. Daraus zieht das selbstlernende System Schlüsse, erkennt Muster und kann dann mit unbekannten Daten besser umgehen. Dabei geht es darum, die Fehlerquote immer weiter zu minimieren.

Ein bekanntes Beispiel für überwachtes Lernen sind Spam-Filter: Anhand von Merkmalen entscheidet das System, ob die Mail im Posteingang landet oder in den Spam-Ordner verschoben wird. Sollte das System einen Fehler machen, können Sie manuell nachjustieren, worauf der Filter seine künftigen Berechnungen anpassen wird. Damit erzielt die Software immer bessere Ergebnisse.

Unsupervised Learning

Beim Unsupervised Learning, also dem unüberwachten Lernen, versucht das Programm, von selbst Muster zu erkennen. Dafür kann es z. B. Clustering anwenden: Aus der Menge an Daten wird ein Element ausgewählt, auf seine Merkmale untersucht und dann mit den bereits untersuchten verglichen. Sollte es schon gleichwertige Elemente untersucht haben, wird das aktuelle Objekt diesen hinzugefügt. Ist dem nicht so, wird es isoliert abgelegt.

Systeme, die auf unüberwachtem Lernen beruhen, werden u. a. in neuronalen Netzen realisiert. Anwendungsbeispiele finden sich in der Netzwerksicherheit: Ein selbstlernendes System erkennt hierbei abnormales Verhalten. Da sich z. B. ein Cyberangriff keiner bekannten Gruppe zuordnen lässt, kann das Programm die Bedrohung erkennen und Alarm schlagen.

Neben diesen beiden Hauptrichtungen existieren noch das teilüberwachte Lernen (Semi-supervised Learning), das bestärkende Lernen (Reinforcement Learning), das aktive Lernen (Active Learning) und das Self-Supervised Learning. Diese Methoden gehören zum überwachten Lernen und unterscheiden sich in Art und Umfang der Beteiligung durch die Nutzenden. Besonders relevant ist heute das letztgenannte Self-Supervised Learning, bei dem die Systeme die Lernaufgaben selbst – ohne Nutzerbeteiligung –erzeugen.

Deep Learning

Im Unterschied zu klassischen ML-Algorithmen wie Entscheidungsbäumen oder Support Vector Machines verwendet Deep Learning mehrschichtige neuronale Netze, um schwerer verständliche Datenmengen zu bearbeiten. Diese sind so komplex, da es sich um natürliche Informationen handelt – z. B. solche, die bei der Sprach-, Handschriften- oder Gesichtserkennung auftreten. Natürliche Daten sind für den Menschen leicht zu verarbeiten, für eine Maschine aber nicht, da sie mathematisch nur schwer zu greifen sind.

Deep Learning und künstliche neuronale Netze hängen eng miteinander zusammen. Die Art, wie man Neural Networks trainiert, kann als Deep Learning beschrieben werden. Tief nennt man es deshalb, weil das Netz der Neuronen in mehreren hierarchischen Ebenen geordnet ist. Man beginnt in der ersten Ebene mit einer Lage an Eingangsneuronen. Diese nehmen die Daten auf, beginnen mit deren Analyse und schicken ihre Ergebnisse an den nächsten neuronalen Knoten. Am Ende erreichen die immer weiter verfeinerten Informationen die Ausgangsebene, und das Netz gibt einen Wert aus. Die mitunter sehr zahlreichen Ebenen, die sich zwischen Eingang und Ausgang befinden, werden versteckte Ebenen („hidden layers“) genannt.

Wie funktioniert Machine Learning für das Marketing?

Für Marketing hat maschinelles Lernen schon heute wichtige Funktionen. Derzeit verwenden aber in erster Linie große Unternehmen ihre Technologien intern, allen voran Google. Selbstlernende Systeme sind noch so neu, dass man sie nicht einfach als Out-of-the-box-Lösung kaufen kann. Stattdessen entwickeln die großen Internetanbieter ihre eigenen Systeme und sind damit Impulsgeber auf diesem Gebiet. Da einige aber trotz des kommerziellen Interesses einen Open-Source-Ansatz verfolgen und mit der unabhängigen Wissenschaft zusammenarbeiten, nehmen die Entwicklungen auf dem Gebiet immer mehr Geschwindigkeit auf.

Datenanalyse und Prognosen

Marketing hat neben der kreativen Seite auch immer einen analytischen Aspekt: Statistiken zum Kundenverhalten spielen eine große Rolle bei der Entscheidung für bestimmte Werbemaßnahmen. Je größer die Datenmenge ist, desto mehr Informationen können in der Regel daraus gezogen werden. Die selbstlernenden Computerprogramme erkennen Muster und können fundierte Voraussagen machen, wozu Menschen, die grundsätzlich voreingenommen mit Daten umgehen, nur begrenzt fähig sind.

Analystinnen und Analysten gehen in der Regel mit einer bestimmten Erwartungshaltung an Messdaten heran. Diese Vorurteile sind für Menschen kaum vermeidbar und oft Grund für Verzerrungen. Je größer die Datenmengen sind, desto stärker dürften die Abweichungen sein. Zwar können auch intelligente Maschinen Vorurteile haben, denn sie wurden von Menschen ungewollt darauf trainiert, aber gerade bei harten Fakten gehen sie objektiver vor. Maschinen liefern daher meist aussagekräftigere Analysen.

Visualisierung

Selbstlernende Systeme verbessern und erleichtern außerdem die Darstellung der Analyse-Ergebnisse: Automated Data Visualization nennt man eine Technik, bei der der Computer selbstständig die richtige Darstellung von Daten und Informationen wählt. Das ist besonders wichtig, damit Menschen auch verstehen, was die Maschine entdeckt und prognostiziert hat. In der großen Datenflut wird es schwierig, Messergebnisse selbst darzustellen. Daher muss auch die Visualisierung über die Berechnungen der Computer laufen.

Personalisierung und generatives Design

Doch auch auf Seiten der Content-Erstellung kann Machine Learning Einfluss nehmen – Stichwort: generatives Design. Statt für alle Nutzenden die gleiche Customer Journey zu entwerfen, können dynamische Systeme basierend auf Machine Learning individuelle Erlebnisse gestalten. Die Inhalte, die auf einer Website angezeigt werden, werden zwar weiterhin von Texterinnen und Textern sowie Designerinnen und Designern bereitgestellt, aber das System fügt die Komponenten speziell für den Nutzenden zusammen. Inzwischen werden selbstlernende Systeme auch eingesetzt, um selbst zu designen oder Inhalte zu verfassen: Mit dem Project Dreamcatcher ist es z. B. möglich, Bauteile von einer Maschine gestalten zu lassen. LLMs wie ChatGPT können darüber hinaus Texte für Websites erstellen, die an Nutzergruppen angepasst sind.

Intelligente Chatbots und Sprachverarbeitung

Man kann Machine Learning auch dazu verwenden, Chatbots zu optimieren. Viele Unternehmen setzen schon heute Programme ein, die einen Teil des Kundensupports über einen Chatbot erledigen. Doch in vielen Fällen sind Nutzende schnell genervt von herkömmlichen Bots. Ein Chatbot hingegen, der auf einem selbstlernenden System basiert und eine gute Spracherkennung (Natural Language Processing) hat, kann Kundinnen und Kunden das Gefühl vermitteln, wirklich mit einer Person zu kommunizieren – und damit den Turing-Test bestehen.

Personalisierte Empfehlungen

Amazon oder Netflix machen eine weitere für Marketer wichtige Entwicklung des Machine Learnings vor: Empfehlungen. Ein großer Faktor für den Erfolg dieser Anbieter besteht darin, vorherzusehen, was ein User als Nächstes haben möchte. Abhängig von den gesammelten Daten können die selbstlernenden Systeme dem Nutzenden weitere Produkte empfehlen. Was früher nur im Großen ging („Unseren Kunden gefällt Produkt A, also wird den meisten auch Produkt B gefallen.“), ist durch moderne Programme inzwischen auch im Kleinen möglich („Der Kundin X haben die Produkte A, B und C gefallen, weshalb ihr wahrscheinlich auch Produkt D gefallen wird.“).

Zusammengefasst lässt sich feststellen, dass selbstlernende Systeme das Onlinemarketing in vier wichtigen Punkten beeinflussen werden:

- Menge: Programme, die mit Machine Learning funktionieren und gut trainiert wurden, können riesige Datenmengen verarbeiten und damit Prognosen für die Zukunft abgeben.

- Geschwindigkeit: Analysen kosten Zeit – wenn man diese von Hand anfertigen muss. Durch selbstlernende Systeme wird die Arbeitsgeschwindigkeit erhöht und man kann schneller auf Veränderungen reagieren.

- Automatisierung: Durch Machine Learning ist es einfacher, Vorgänge zu automatisieren. Da sich moderne Systeme mithilfe des maschinellen Lernens eigenständig an neue Gegebenheiten anpassen können, sind auch komplexe Automatisierungsprozesse möglich.

- Individualität: Computerprogramme können unzählige Kundinnen und Kunden betreuen. Da selbstlernende Systeme Daten von einzelnen Nutzenden erfassen und verarbeiten, können sie diese auch individuell beraten.

Andere Einsatzbereiche von selbstlernenden Systemen

Aber nicht nur im Marketing wird schon heute vermehrt auf Machine Learning gesetzt. In vielen weiteren Bereichen unseres Lebens halten selbstlernende Systeme Einzug. Teilweise helfen diese in Wissenschaft und Technik, den Fortschritt noch weiter voranzutreiben. In manchen Fällen werden sie aber auch einfach in Form von mal größeren, mal kleineren Gadgets eingesetzt, um unseren Alltag zu vereinfachen. Die vorgestellten Einsatzgebiete sind nur beispielhaft. Es ist davon auszugehen, dass Maschinenlernen in nicht allzu ferner Zukunft unser komplettes Leben beeinflussen wird.

Hosting

Auch Hosting- und Cloud-Anbieter wie IONOS integrieren zunehmend KI-basierte Systeme, um kleinen und mittleren Unternehmen den Zugang zu Machine Learning zu erleichtern. Mit IONOS GPT steht ein KI-Assistent zur Verfügung, der speziell auf die Bedürfnisse von Geschäftskunden zugeschnitten ist. Der Assistent hilft beim Verfassen von Website-Texten, beim Erstellen von Produktbeschreibungen oder beim Schreiben von Code.

Dabei greift IONOS GPT auf generative KI zurück, um kontextbezogene Inhalte zu liefern, die zur Branche und Zielgruppe passen. Im Gegensatz zu allgemeinen Sprachmodellen ist IONOS GPT gezielt auf die Anwendung im Business- und Marketingumfeld ausgerichtet. So profitieren auch kleinere Betriebe, Selbstständige und Startups von den Vorteilen generativer KI, ohne dafür ein eigenes System aufbauen zu müssen.

Wissenschaft

Was fürs Marketing gilt, hat in den Naturwissenschaften eine noch größere Bedeutung. Die intelligente Verarbeitung von Big Data ist für empirisch arbeitende Wissenschaftlerinnen und Wissenschaftler eine enorme Erleichterung. Teilchenphysiker und -physikerinnen haben durch selbstlernende Systeme z. B. die Möglichkeit, viel mehr Messdaten aufzunehmen, zu verarbeiten und so Abweichungen festzustellen. Aber auch in der Medizin hilft Machine Learning: Schon heute setzen einige Medizinerinnen und Mediziner künstliche Intelligenz bei der Diagnose und Behandlung ein. Außerdem dient Maschinenlernen der Prognose, etwa von Diabetes oder Herzinfarkten.

Robotik

Besonders in Fabriken sind Roboter inzwischen allgegenwärtig. Sie helfen z. B. bei der Massenfertigung, um gleichbleibende Arbeitsschritte zu automatisieren. Mit intelligenten Systemen haben sie allerdings oft wenig zu tun, da sie nur für den Arbeitsschritt programmiert wurden, den sie ausführen. Werden selbstlernende Systeme in der Robotik eingesetzt, dann sollen diese Maschinen auch neue Aufgaben meistern. Diese Entwicklungen sind selbstverständlich auch für andere Bereiche hochinteressant: Von der Raumfahrt bis zum Haushalt werden Roboter mit künstlicher Intelligenz in zahlreichen Bereichen zum Einsatz kommen.

Verkehr

Ein großes Aushängeschild von Machine Learning sind selbstfahrende Autos. Dass Fahrzeuge selbstständig und unfallfrei durch den realen Verkehr – statt nur durch Testparcours – manövrieren, kann nur durch maschinelles Lernen gelingen. Es ist nicht möglich, alle Situationen zu programmieren. Deshalb ist es zwingend notwendig, dass Autos, die selbst navigieren sollen, auf intelligente Maschinen zurückgreifen. Aber nicht nur beim individuellen Transportmittel revolutionieren selbstlernende Systeme den Verkehr: Intelligente Algorithmen, z. B. in Form von künstlichen neuronalen Netzen, können den Verkehr analysieren und effektivere Verkehrsleitsysteme entwickeln, etwa durch intelligente Ampelschaltungen.

Internet

Bereits jetzt spielt Machine Learning eine große Rolle im Internet. Ein Beispiel sind Spam-Filter: Durch beständiges Lernen werden Filter für unerwünschte Mails immer besser und verbannen Spam verlässlicher aus dem Posteingang. Das Gleiche gilt für die intelligente Abwehr von Viren und Malware, durch die Computer besser vor Schadsoftware geschützt werden. Auch Rankingalgorithmen von Suchmaschinen – allen voran RankBrain von Google – sind selbstlernende Systeme. Selbst wenn der Algorithmus mit der Nutzereingabe nichts anzufangen weiß (weil noch niemand danach gesucht hat), kann er eine Vermutung anstellen, was auf die Anfrage passen könnte.

Persönliche Assistenten

Sogar in den eigenen vier Wänden nehmen Computersysteme, die stetig lernen, eine immer wichtigere Rolle ein. So werden aus einfachen Wohnungen Smart Homes. Moley Robotics entwickelt beispielsweise eine intelligente Küche, die mit maschinellen Armen ausgestattet Mahlzeiten zubereitet. Auch die persönlichen Assistenten wie Google Home und Amazon Echo, mit denen Teile der eigenen Wohnung gesteuert werden können, verwenden Machine-Learning-Technologien, um ihre Nutzenden bestmöglich zu verstehen. Viele Menschen tragen ihre Assistenten inzwischen aber auch stets mit sich: Mit Siri, Cortana oder dem Google Assistant können Nutzer per Sprachsteuerung Befehle und Fragen an ihre Smartphones stellen.

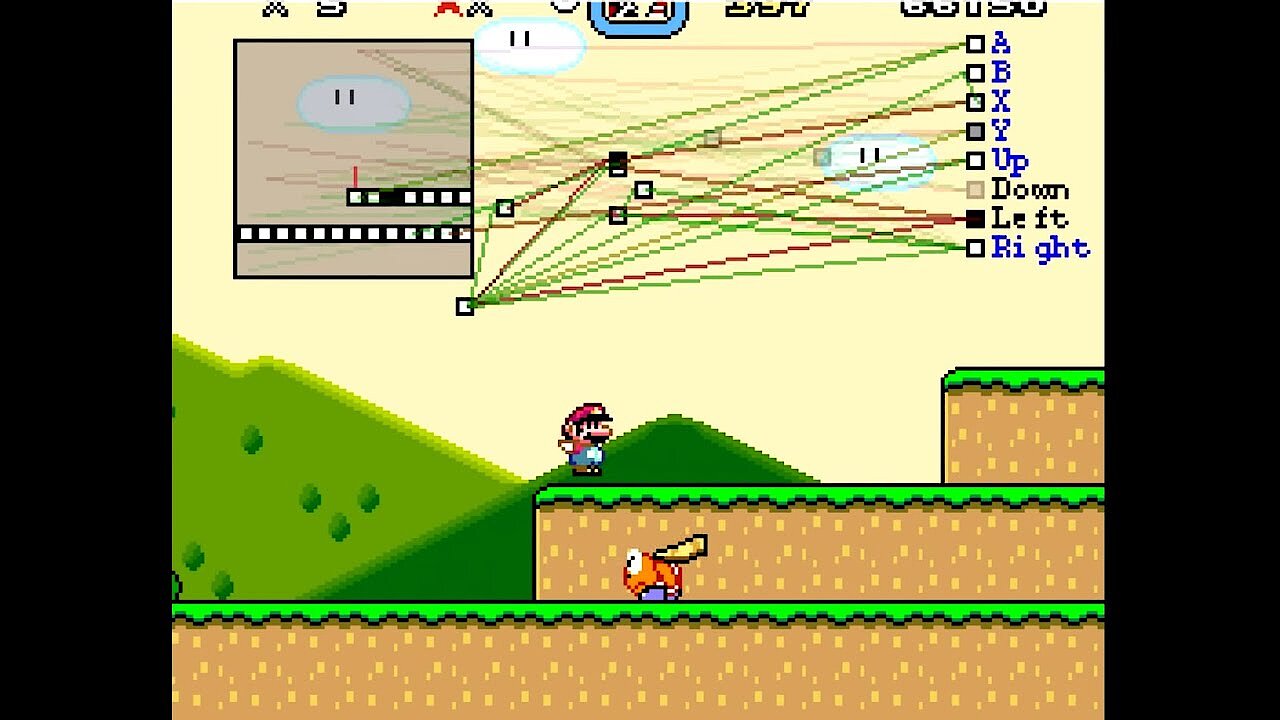

Spiele

Seit Beginn der Forschung rund um künstliche Intelligenz war die Fähigkeit der Maschinen, Spiele zu spielen, ein großer Antrieb für Forschende. In Schach, Dame oder dem aus China stammenden Go (das vielleicht komplexeste Brettspiel der Welt) haben sich selbstlernende Systeme gegen menschliche Gegner gemessen. Auch Computerspiele-Entwickelnde greifen zu Machine Learning, um ihre Spiele interessanter zu gestalten. Spieledesignerinnen und -designer können maschinelles Lernen einsetzen, um ein möglichst ausgewogenes Gameplay zu kreieren und dafür zu sorgen, dass sich Computergegner intelligent an das Verhalten der menschlichen Spielerinnen und Spieler anpassen.

Zur Anzeige dieses Videos sind Cookies von Drittanbietern erforderlich. Ihre Cookie-Einstellungen können Sie hier aufrufen und ändern.

Zur Anzeige dieses Videos sind Cookies von Drittanbietern erforderlich. Ihre Cookie-Einstellungen können Sie hier aufrufen und ändern. Die Geschichte der selbstlernenden Systeme

Roboter und Automaten beschäftigen die Menschheit bereits mehrere Jahrhunderte lang. Dabei bewegt sich das Verhältnis des Menschen zur denkenden Maschine von jeher zwischen Furcht und Faszination. Die eigentlichen Bemühungen um Machine Learning begannen allerdings erst in den 1950er-Jahren, zu einer Zeit also, als Computer noch in den Kinderschuhen steckten und man von künstlicher Intelligenz nur träumen konnte. Zwar hatten schon in den zwei Jahrhunderten davor Theoretiker wie Thomas Bayes, Adrien-Marie Legendre und Pierre-Simon Laplace Grundsteine für die spätere Forschung gelegt, aber erst mit der Arbeit von Alan Turing wurde die Idee der lernfähigen Maschinen konkret.

„In such a case one would have to admit that the progress of the machine had not been foreseen when its original instructions were put in. It would be like a pupil who had learnt much from his master, but had added much more by his own work. When this happens I feel that one is obliged to regard the machine as showing intelligence.” Alan Turing bei einer Vorlesung im Jahre 1947. (Zitiert nach B. E. Carpenter and R. W. Doran (eds.), A. M. Turing’s ACE Report of 1946 and Other Papers)

1950 entwickelte Turing seinen bis heute bekannten Turing-Test – eine Art Spiel, bei dem ein Computer einem Menschen vorgibt, auch ein Mensch zu sein. Erkennt der Mensch nicht mehr, dass er gar nicht mit einer Person aus Fleisch und Blut redet, hat die Maschine den Test bestanden. So weit war man damals noch lange nicht, aber bereits zwei Jahre später entwickelte Arthur Samuel einen Computer, der Dame spielen konnte – und mit jedem Spiel besser wurde. Das Programm hatte die Fähigkeit, zu lernen. 1957 schließlich entwickelte Frank Rosenblatt mit dem Perzeptron einen ersten Algorithmus, der angeleitet lernen konnte – ein künstliches neuronales Netz.

Inzwischen gehören große Unternehmen zu den Impulsgebern in der Entwicklung von Machine Learning: IBM hat mit Watson einen Computer entwickelt, der einen immensen Wissensspeicher besitzt und auf Fragen antworten kann, die in natürlicher Sprache gestellt werden. Google und Meta setzen Machine Learning ein, um ihre Nutzenden besser zu verstehen und ihnen mehr Funktionen zu bieten.