robots.txt bei WordPress: So richten Sie die Datei ein

Nicht jede Unterseite oder alle Verzeichnisse auf Ihrer Website sind so wichtig, dass sie unbedingt von den gängigen Suchmaschinen gecrawlt werden sollten. Mit Hilfe der Datei robots.txt können Sie bestimmen, welche WordPress-Unterseiten vom Crawler berücksichtigt werden sollen und welche nicht. So platzieren Sie Ihre Website deutlich besser bei der Onlinesuche. Hier erklären wir Ihnen, was robots.txt bei WordPress bewirkt und wie Sie die Datei selbst optimieren.

- Inklusive Wildcard-SSL-Zertifikat

- Inklusive Domain Lock

- Inklusive 2 GB E-Mail-Postfach

Was ist robots.txt für WordPress?

Rund um die Uhr durchsuchen sogenannte Crawler das Internet nach Webseiten. Diese Bots werden von den jeweiligen Suchmaschinen losgeschickt und erfassen möglichst viele Seiten und Unterseiten (Indexierung), um sie für die Suche verfügbar zu machen. Damit die Crawler Ihre Website gut auslesen können, müssen sie geleitet werden. So vermeiden Sie, dass Inhalte Ihrer Seite indexiert werden, die für Suchmaschinen irrelevant sind, und stellen sicher, dass der Crawler nur die Inhalte ausliest, der er auslesen soll.

Für diese Steuerung können Sie die robots.txt verwenden. Bei WordPress und anderen CMS bestimmen Sie mit dieser Datei, welche Bereiche Ihrer Website von den Crawlern erfasst werden und welche nicht. Über die robots.txt können Sie Bots ausschließen oder zulassen und auch genaue Unterscheidungen treffen, welche Suchmaschinen welche Einträge finden und dann in der Suche ausspielen. Da jede Domain nur ein limitiertes Crawling-Budget hat, ist es umso wichtiger, die Hauptseiten zu pushen und unbedeutende Unterseiten aus dem Suchvolumen zu nehmen.

In wenigen Schritten zur Traum-Domain! Registrieren Sie bei IONOS ganz bequem Ihre perfekte Domain und profitieren Sie von hervorragendem Service, zahlreichen Sicherheitsfeatures und einem 2 GB großen E-Mail-Postfach.

Wofür wird robots.txt bei WordPress benötigt?

Es hat große Vorteile, wenn robots.txt bei WordPress genau festlegt, welche Inhalte indiziert werden und welche nicht. Während etwa Ihre Startseite bei möglichst jeder passenden Suche eine gute Platzierung im Ranking haben sollte, gilt das für das Impressum Ihrer Seite nicht. Auch Kommentare oder Archive sorgen in der Suche für keinen Mehrwert und können im Gegenteil sogar Nachteile bringen – dann nämlich, wenn die Suchmaschinen hier Duplicate Content erkennen und diesen negativ bewerten. Mit einer robots.txt-Datei bei WordPress schließen Sie solche Fälle bestmöglich aus und lenken die unterschiedlichen Crawler stattdessen auf die Bereiche Ihrer Website, die wirklich gefunden werden sollen.

Die automatische robots.txt-Datei von WordPress

Zu Anfang erstellt WordPress selbst eine robots.txt-Datei und leistet damit eine grundsätzliche Vorarbeit. Allerdings ist diese wenig umfangreich und sollte daher vor allem als Startpunkt gesehen werden. Sie sieht so aus:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/Der „User-agent“ in der ersten Zeile meint hier die Crawler. „*“ drückt aus, dass alle Suchmaschinen ihre Bots zu Ihrer Seite schicken dürfen. Das ist grundsätzlich erstmal empfehlenswert, da so Ihre Website auch häufiger gefunden wird. Der Befehl „Disallow“ sperrt die nachfolgenden Verzeichnisse für die Crawler – in diesem Fall sind das die Administration und das Verzeichnis aller Dateien bei WordPress. robots.txt sperrt diese für Suchmaschinen, da Besucher nichts auf den jeweiligen Seiten zu suchen haben. Damit sie tatsächlich nur von Ihnen aufgerufen werden können, schützen Sie diese Bereiche mit einem guten Passwort.

Als Administrator können Sie Ihren WordPress-Login zusätzlich über die .htaccess-Datei schützen.

Was gehört in eine robots.txt-Datei bei WordPress?

Suchmaschinen wie Google sollten Ihre Seite natürlich auch weiterhin gut finden können. Eher schädliche oder zwielichtige Services wie DuggMirror allerdings nicht; diese schließen Sie mit robots.txt bei WordPress aus. Dazu sollten Sie Themes, Ihr Impressum und andere Seiten, die keine oder nur geringe Relevanz haben, von der Indexierung ausnehmen. Auch Plugins sollten nicht indiziert werden – nicht nur, weil sie für die Öffentlichkeit nicht relevant sind, sondern auch aus Sicherheitsgründen. Hat ein Plugin eine Sicherheitsproblem, kann Ihre Website von Angreifern auf diese Weise gefunden und beschädigt werden.

In den meisten Fällen reichen Ihnen die beiden oben bereits genannten Befehle, um robots.txt bei WordPress sinnvoll zu nutzen: „User-agent“ legt fest, welche Bots angesprochen werden sollen. So können Sie Ausnahmen für bestimmte Suchmaschinen bestimmen oder auch grundsätzliche Regeln aufstellen. „Disallow“ verbietet Crawlern den Zugriff auf eine entsprechende Seite oder Unterseite. Der dritte Befehl „Allow“ ist in den meisten Fällen nicht von Belang, da der Zugriff standardmäßig erlaubt ist. Lediglich wenn Sie eine Seite sperren, aber deren Unterseite freigeben möchten, benötigen Sie diesen Befehl.

Der schnellste Weg zur eigenen Website: WordPress-Hosting von IONOS besticht durch zahlreiche Vorteile. SSD, HTTP/2 und gzip sind ebenso inklusive wie drei dauerhaft kostenlose Domains. Wählen Sie das Tarifmodell, das am besten zu Ihnen passt!

Robots.txt bei WordPress manuell ändern

Für individuelle Anpassungen ist es gut, wenn Sie die robots.txt bei WordPress selbst erweitern. Dafür benötigen Sie nur wenige einfache Schritte.

Schritt 1: Zuerst erstellen Sie in einem beliebigen Texteditor eine leere Datei namens „robots.txt“.

Schritt 2: Diese laden Sie dann im Root-Verzeichnis Ihrer Domain hoch.

Schritt 3: Nun können Sie die Datei entweder per SFTP bearbeiten oder einen neue Text-Datei hochladen.

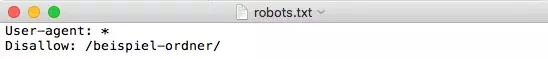

Mit den oben erläuterten Befehlen steuern Sie nun, welche Regeln und Ausnahmen auf Ihrer Website gelten. So sperren Sie den Zugriff auf einen bestimmten Ordner:

Plugins für die Erstellung einer robots.txt-Datei bei WordPress

Sie können die robots.txt-Datei bei WordPress auch mit einem SEO-Plugin erstellen und ändern. Das erfolgt ganz bequem und sicher im Dashboard und kann somit noch einfacher sein. Ein beliebtes Plugin für diesen Zweck ist Yoast SEO.

Schritt 1: Zunächst müssen Sie das Plugin installieren und aktivieren.

Schritt 2: Erlauben Sie dann dem Plugin, erweiterte Änderungen vorzunehmen. Dafür gehen Sie auf „SEO“ > „Dashboard“ >, „Features“ und klicken unter dem Punkt „Advanced settings pages“ auf „Enabled“.

Schritt 3: Nach dieser Aktivierung nehmen Sie Änderungen im Dashboard unter „SEO“ > „Tools“ > „File editor“ vor. Dort können Sie direkt eine neue robots.txt-Datei bei WordPress erstellen und bearbeiten. Die Modifikationen werden dann direkt umgesetzt.

Wie können Sie Änderungen testen?

Nun haben Sie Ihre Website eingestellt, Regeln festgesetzt und zumindest in der Theorie Crawler ausgesperrt und Unterseiten unsichtbar gemacht. Wie aber stellen Sie fest, ob all Ihre Änderungen auch tatsächlich so durchgeführt wurden? Dabei hilft Ihnen die Google Search Console. In dieser finden Sie auf der linken Seite unter „Crawl“ den „robots.txt Tester“. Dort geben Sie Ihre Seiten und Unterseiten ein und sehen dann, ob diese gefunden werden können oder gesperrt sind. Ein grünes „allowed“ am unteren rechten Rand bedeutet, dass die Crawler die Seite finden und berücksichtigen, ein rotes „disallowed“ heißt, die Seite wird nicht indiziert.

- In Sekunden zur professionellen WordPress Website mit KI-Tools

- Jetzt bis zu 3x schneller dank SSD, Caching & optimierter Plattform

- Tägliche Sicherheits-Scans, DDoS-Schutz und 99,98 % Verfügbarkeit

Fazit: robots.txt optimiert und schützt Ihre Website

Die Datei robots.txt ist für WordPress eine ebenso simple wie effektive Methode, um festzulegen, welche Bereiche Ihrer Seite von wem gefunden werden sollen. Wenn Sie sowieso bereits ein SEO-Plugin wie Yoast nutzen, ist es am einfachsten, die Änderungen damit vornehmen. Ansonsten lässt sich die Datei aber auch problemlos manuell erstellen und anpassen.

Im IONOS Digital Guide finden Sie wertvolle Tipps rund um das Thema WordPress. Wir helfen Ihnen dabei, die häufigsten WordPress-Fehler zu vermeiden, erklären Ihnen, wie Sie WordPress schneller machen, und zeigen Ihnen, was es mit WordPress Gutenberg auf sich hat. Hier finden Sie mit Sicherheit passende Antworten.