Hyperscale-Computing

Der Begriff „Hyperscale“ kann ins Deutsche übersetzt werden mit „übermäßig große Skalierbarkeit“. Der Terminus wird in der Computerwelt für eine bestimmte Organisationsform von Servern benutzt.

- Kostengünstige vCPUs und leistungsstarke dedizierte Cores

- Höchste Flexibilität ohne Mindestvertragslaufzeit

- Inklusive 24/7 Experten-Support

Was ist Hyperscale?

Der Begriff Hyperscale eschreibt skalierbare Cloud-Computing-Systeme, in denen eine sehr große Zahl von Servern in einem Netzwerk verbunden ist. Die Zahl der genutzten Server kann je nach Bedarf vergrößert oder verkleinert werden. Ein solches Netzwerk kann sehr viele Zugriffe verarbeiten, bei geringer Auslastung aber auch geringere Kapazitäten bereitstellen.

Die Skalierbarkeit ist der eigentliche Ausdruck dafür, dass sich das Netzwerk auf wechselnde Leistungsanforderungen anpasst. Hyperscale-Server sind kleine einfache Systeme, die exakt auf einen festgelegten Zweck abgestimmt sind. Um die Skalierbarkeit zu erreichen, werden sie horizontal miteinander vernetzt. Horizontal beschreibt den Umstand, dass zur Steigerung der Leistung eines IT-Systems weitere Serverkapazitäten hinzugefügt werden. Im internationalen Sprachgebrauch wird auch der Begriff Scale-out dafür verwendet.

Das dem gegenüberstehende Verfahren der vertikalen Skalierbarkeit (Scale-up) beschreibt den Ausbau eines bestehenden lokalen Systems. Dazu wird ein bestehendes Rechnersystem mit besserer Hardware, also größerem Hauptspeicher, schnellerer CPU, leistungsfähigeren Festplatten oder schnelleren Grafikkarten aufgerüstet. In der Praxis wird oft vor der horizontalen Skalierung zuerst die Technik vor Ort aufgerüstet – bis an die Grenzen des technisch Machbaren oder die Grenzen der akzeptablen Hardware-Kosten. Dann ist der Schritt zum Hyerscaler meist unumgänglich.

Wie funktioniert Hyperscale?

Beim Hyperscale-Computing werden einfach gestaltete Server horizontal vernetzt. Das Wort „einfach“ meint hierbei nicht „primitiv“, sondern „gut zusammenfügbar“. Es bestehen also wenige und grundlegende Konventionen – z. B. Netzwerkprotokolle. Damit ist die Kommunikation der Server untereinander einfach zu verwalten.

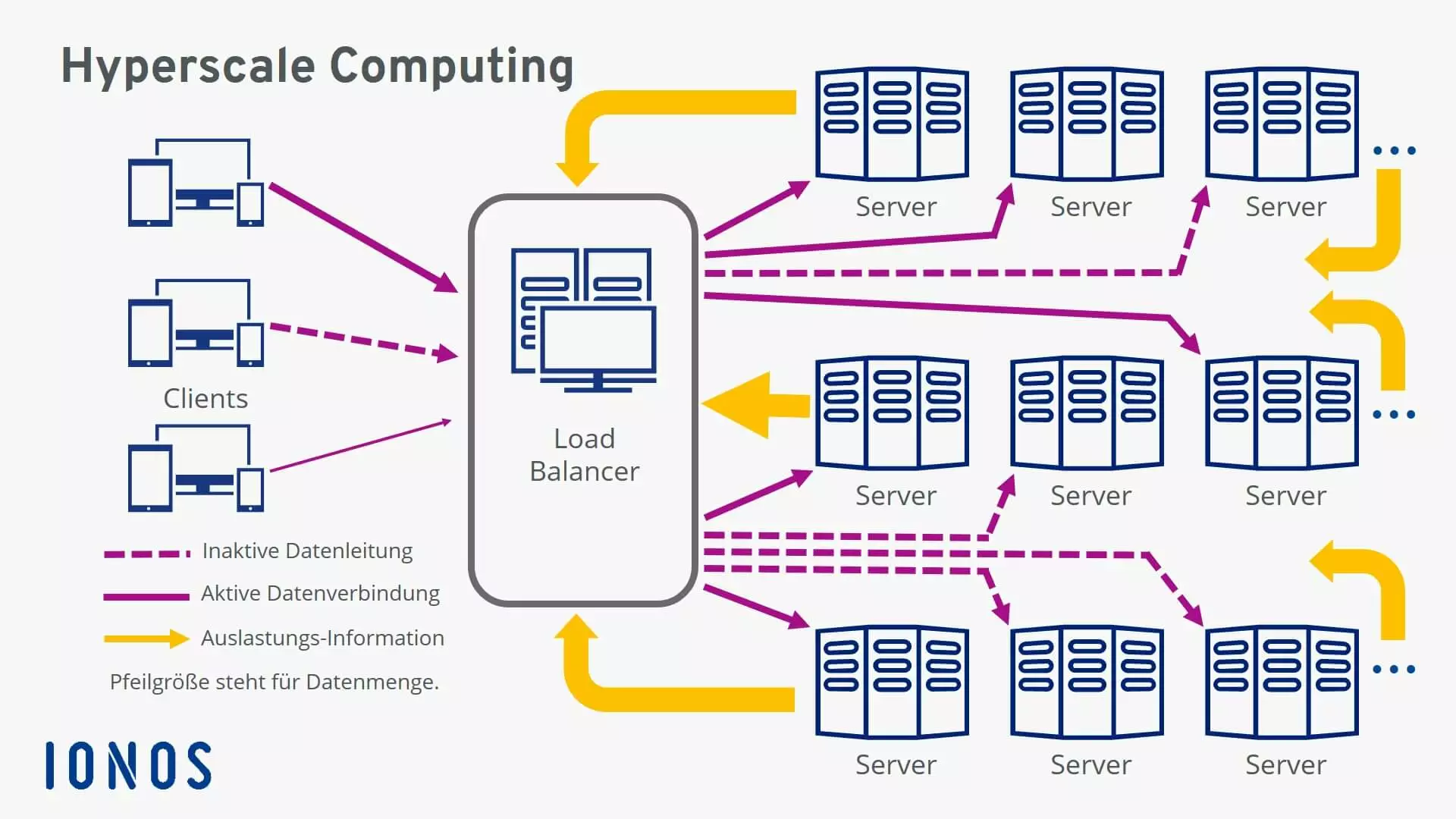

Die „Ansprache“ der momentan benötigten Server erfolgt mit einem Rechner, der die eintreffenden Anfragen verwaltet und an die freien Kapazitäten verteilt, dem sogenannten Load Balancer. Dabei wird beständig kontrolliert, inwieweit die genutzten Server mit den zu verarbeitenden Datenvolumina ausgelastet sind, und bei Bedarf werden weitere Server dazugeschaltet oder bei abnehmendem Request auch wieder abgeschaltet.

Verschiedene Analysen haben ergeben, dass in Unternehmen lediglich 25 bis 30 Prozent der vorliegenden Daten aktiv genutzt werden. Zu den ungenutzten Datenbeständen gehören z. B. Sicherheitskopien, Kundendaten, Wiederherstellungsdaten. Ohne ein straffes Ordnungssystem sind diese Daten bei Bedarf schwer aufzufinden, Backups können unter Umständen Tage in Anspruch nehmen. Das alles wird mit Hyperscale-Computing vereinfacht. Die komplette Hardware für Computing, für Speicher und Netzwerke hat dann nur noch einen Kontaktpunkt zu Datensicherungen, Betriebssystemen und anderer benötigter Software. Die Kombination von Hardware und unterstützenden Einrichtungen erlaubt es, die aktuell benötigte Computing-Umgebung auf mehrere Tausend Server auszubauen.

Das begrenzt übermäßiges Kopieren von Daten und vereinfacht die Anwendung von Richtlinien und Sicherheitskontrollen in Unternehmen, sodass letztlich auch Personal- und Verwaltungskosten sinken.

Vorteile und Nachteile von Hyperscale-Computing

Die beschriebene Möglichkeit, Serverkapazitäten einfach zu erweitern oder wieder zu verringern, hat Licht- und Schattenseiten.

Die Vorteile

- Der Skalierung sind keine Grenzen gesetzt, Unternehmen bleiben flexibel für zukünftige Datenmengen gerüstet. Das erlaubt eine schnelle und kostengünstige Marktanpassung.

- Unternehmen müssen langfristige Strategien für die Entwicklung der eigenen IT besitzen.

- Die Anbieter des Hyperscale-Computing garantieren eine hohe Ausfallsicherheit durch redundante Lösungen.

- Vermeidung von Abhängigkeiten durch die zeitgleiche Nutzung mehrerer Anbieter.

- Klar kalkulierbare Kosten und große Kosteneffizienz unterstützen optimal bei der Realisierung von Unternehmenszielen.

Die Nachteile

- Es werden Daten aus der Hand gegeben.

- Neu hinzugefügte Speicher-/Server-Kapazitäten können auch neue Fehlerquellen sein.

- Es entstehen größere Anforderungen an das innerbetriebliche Management und die Verantwortung der Mitarbeiter – langfristig gesehen allerdings ein Vorteil.

- Die Nutzer begeben sich in die Abhängigkeit vom Preismodell des Hyperscale-Anbieters.

- Jeder Anbieter hat seine eigene Bedienoberfläche.

Um Vor- und Nachteile gut gegeneinander abwägen zu können, können Unternehmen einen hybriden Weg wählen und große Backups oder selten benötigte Daten in einer Cloud ablegen. Diese Daten nehmen damit nicht die Speicherkapazitäten eines innerbetrieblichen Rechenzentrums in Anspruch. Beispiele sind persönliche Daten von Nutzern eines Onlineshops, die auf Verlangen der Nutzer herausgegeben bzw. gelöscht werden müssen, oder aufbewahrungspflichtige Unternehmensdaten.

Was ist ein Hyperscaler?

Unter einem Hyperscaler versteht man den Betreiber eines Rechenzentrums, das skalierbare Cloud-Computing-Dienste anbietet. Als erstes Unternehmen hat Amazon diesen Markt im Jahre 2006 mit den Amazon Web Services (AWS) betreten. Dabei handelt es sich um ein Tochterunternehmen, mit dessen Hilfe die eigenen Amazon-Rechenzentren weltweit besser ausgelastet werden sollen. Inzwischen bietet AWS sehr viele spezifische Dienste an. Der Marktanteil beträgt zirka 40 Prozent. Die beiden anderen Big Player auf diesem Markt sind Microsoft mit dem Dienst Azure (2010) und die Google Cloud Platform (2010). Auch das Unternehmen IBM gilt als größerer Anbieter von Hyperscale-Computing. Diese technischen Möglichkeiten werden über autorisierte Partner auch mittels Rechenzentren am Standort Deutschland angeboten – für viele Unternehmen ein wichtiger Gesichtspunkt, besonders seit Inkraftsetzung der neuen Datenschutzgrundverordnung.

Mit IONOS Cloud präsentiert IONOS eine Alternative zu den großen US-Hyperscalern. Der Fokus liegt hier auf Infrastructure as a Service (IaaS), mit Angebote wie Compute Engine, Managed Kubernetes, S3 Object Storage oder eine Private Cloud.