Datenmigration mit rclone – so funktioniert’s

rclone ist ein freies Tool zur Datenmigration, das für diverse Linux/Unix-Plattformen, Windows und macOS bereitgestellt wird. Die Installation besteht im einfachsten Fall aus dem Entpacken eines ZIP-Archivs. Einmal eingerichtet unterstützt rclone über 70 verschiedene Cloud-Speicher sowie alle wichtigen Übertragungsprotokolle wie FTP(S) und HTTP(S).

So installieren Sie rclone auf Ihrem System

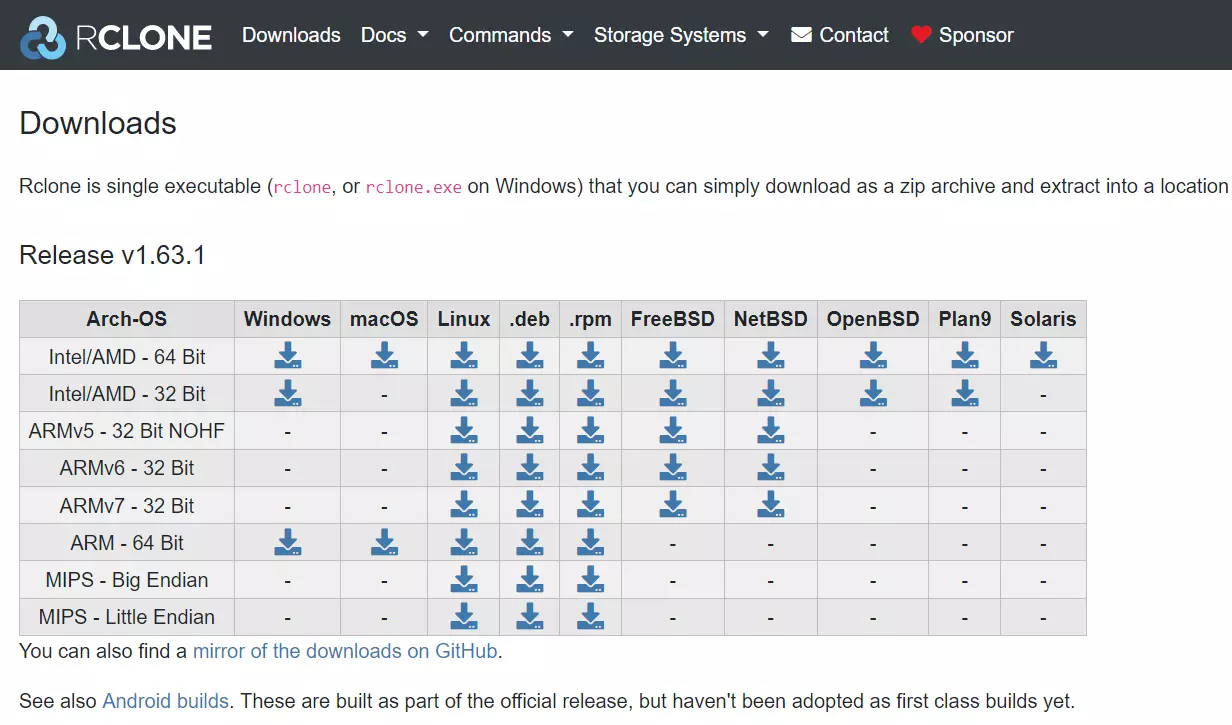

Für die Installation von rclone benötigen Sie das passende Installationspaket. Eine detaillierte, übersichtliche Auflistung gibt es im offiziellen Download-Bereich der rclone-Website. Dort finden Sie u. a. auch experimentelle Betaversionen sowie verschiedene ältere Versionen der Datenmigrationssoftware.

Für die Installation unter Linux und macOS rufen Sie das Terminal auf und führen dort folgenden Befehl aus:

sudo -v ; curl https://rclone.org/install.sh | sudo bashAls Nutzer oder Nutzerin eines Windows-Systems laden Sie einfach das für Ihr System geeignete ZIP-Paket herunter (32- oder 64-Bit). Im Anschluss entpacken Sie den Ordner.

Da rclone ein Kommandozeilen-Tool ist, können Sie die entpackte rclone.exe nicht auf gewohntem Weg per Doppelklick ausführen – Konfiguration und Bedienung des Tools funktionieren ausschließlich über die Eingabeaufforderung.

rclone konfigurieren: So funktioniert’s

Sie können nun jederzeit die grundlegenden Einstellungen für Datenmigrationen, Backups und Datenwiederherstellung festlegen und Ihre präferierten Cloud-Speicher-Dienste einrichten. Hierfür starten Sie die Eingabeaufforderung bzw. das Terminal und navigieren im ersten Schritt in das Verzeichnis der rclone.exe. Wir haben die Software unter Windows beispielsweise direkt in dem Verzeichnis C:\rclone abgelegt, sodass der entsprechende CMD-Befehl wie folgt lautet:

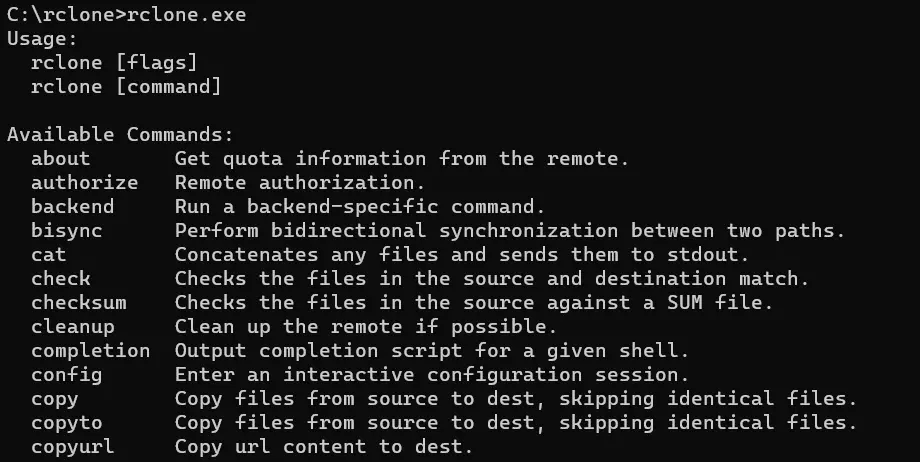

cd C:\rcloneIn dem Pfad starten Sie die Software für das Datenmanagement, indem Sie rclone.exe eintippen und die Startdatei per Eingabetaste ausführen. Nach dem Start präsentiert Ihnen rclone eine Übersicht der verfügbaren Befehle.

Anschließend rufen Sie das Konfigurationsmenü über das folgende Kommando auf:

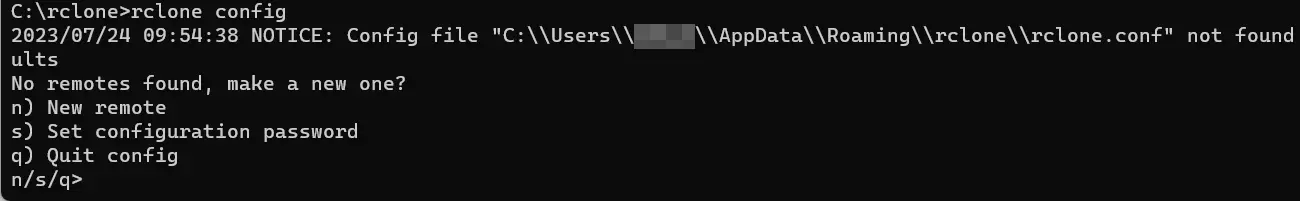

rclone configBeim ersten Aufruf erhalten Sie die Information, dass keine Konfigurationsdatei gefunden wurde. Gleiches gilt für Remote-Verbindungen zu Cloud-Storages. Sie können im ersten Schritt eine solche Fernverbindung einrichten (n), ein Konfigurations-Passwort festlegen (s) oder das Menü verlassen (q).

Remote-Verbindungen konfigurieren

Um in rclone eine neue Fernverbindung für den Zugang zu Cloud-Speichern einzurichten, wählen Sie im Konfiguratiosdialog die Option „n) New remote“. Tippen Sie hierfür den Buchstaben [n] ein und bestätigen Sie Ihre Auswahl mit der Eingabetaste (gilt auch für alle nachfolgenden Schritte).

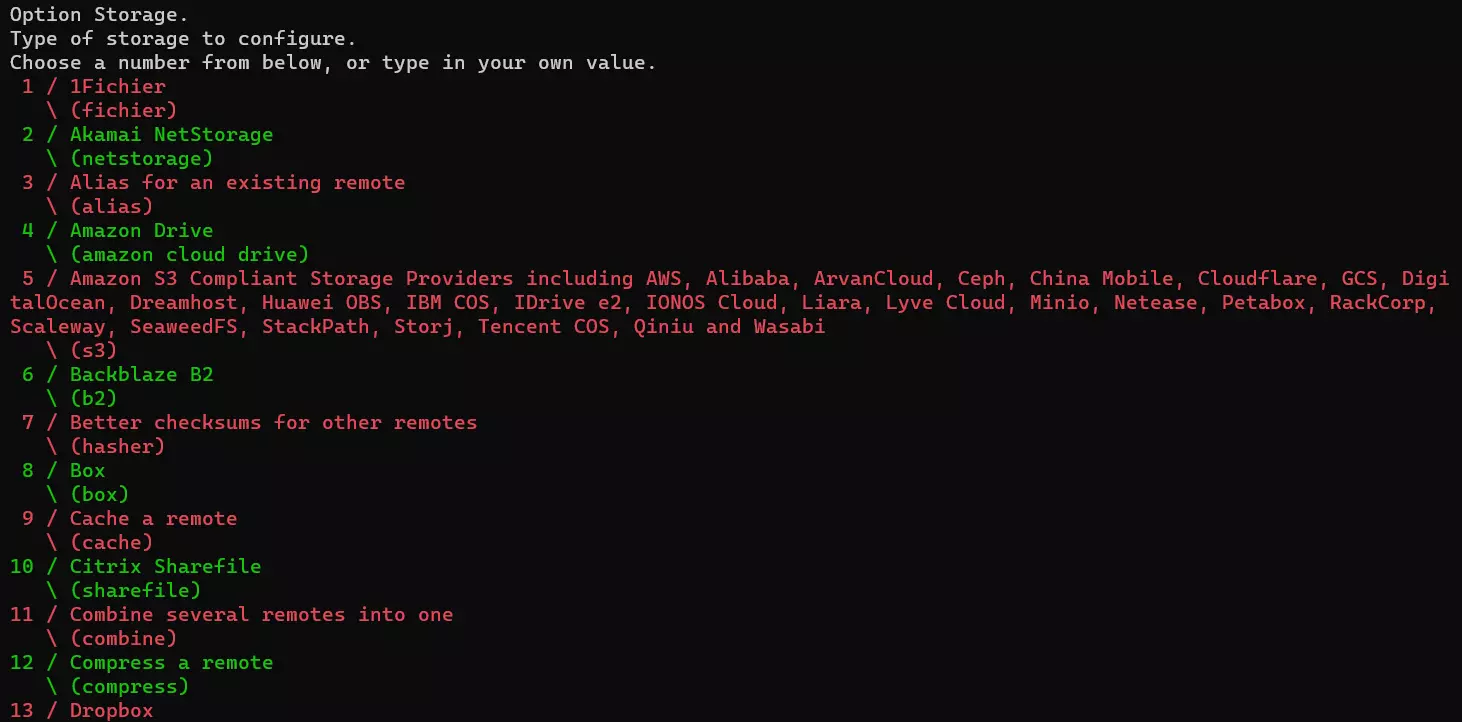

Als nächstes wählen Sie einen Namen für die Remote-Verbindung. Am besten nutzen Sie den jeweiligen Namen des Cloud-Speichers bzw. der Speicherumgebung – also zum Beispiel Amazon Drive, IONOS S3 Objekt Storage oder Meine-Website-FTP. Im Anschluss präsentiert rclone eine Liste an verfügbaren Arten von Cloud Storages. Mit der entsprechenden Nummer geben Sie an, um welchen Typ es sich bei Ihrem Dienst handelt.

Es folgen Angaben zum S3-Provider, zu den Zugangsdaten und zum Serverstandort. Im letzten Schritt definieren Sie die Zugriffskontrolle. Für den privaten Zugriff (niemand außer Ihnen kann die Fernverbindung nutzen) wählen Sie beispielsweise die „1“. Abschließend können Sie die erweiterte Config aufrufen oder die Konfiguration beenden.

Ersetzen Sie eigene, kostenintensive Speicherlösungen mit IONOS Object Storage. Es ist hochgradig skalierbar, äußerst kosteneffizient und integriert sich in Ihre Anwendungsszenarien. Die extrem hohe Ausfallsicherheit unserer Server sowie eine individuelle Zugriffssteuerung schützen Ihre Daten zuverlässig.

Remote-Verbindungen editieren/löschen

Nachdem Sie eine oder mehrere Remote-Verbindungen in rclone angelegt haben, wird das initiale Konfigurationsmenü automatisch erweitert. Sie sehen nicht nur eine Auflistung der konfigurierten Verbindungen („Current remotes“); es kommen außerdem die folgenden Auswahlmöglichkeiten hinzu:

- Edit existing remote (e) : Mithilfe dieser Option können Sie eingerichtete Fernverbindungen jederzeit anpassen.

- Rename remote (r): Sie wollen nachträglich Ordnung in Ihre eingerichteten Remote-Verbindungen bringen? Passendere Namen vergeben Sie mit der

rename-Funktion. - Copy remote (c): Vorhandene Fernverbindungen lassen sich dank

copy-Funktion als Vorlage nutzen. - Delete remote (d) : Falls Sie Verbindungen nicht mehr benötigen, können Sie diese mit der

delete-Option jederzeit löschen.

rclone-Passwort definieren

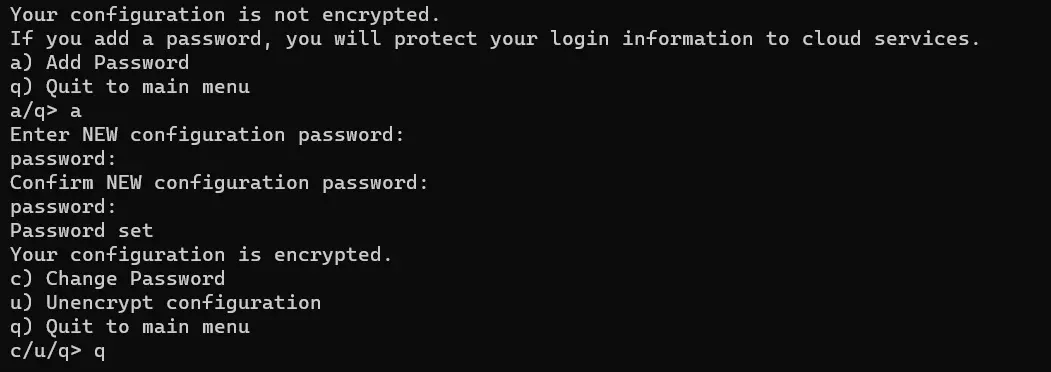

Bei den Informationen, die Sie für die Fernverbindungen in rclone angeben, handelt es sich um vertrauliche Daten, die nicht in die Hände fremder Personen gelangen sollen. Aus diesem Grund gibt es die Möglichkeit, den Zugang zum Konfigurationsmenü – sowie die späteren Kommandos für die Datenübertragung – durch ein persönliches Passwort zu sichern.

Starten Sie die Einrichtung, indem Sie die Taste [s] drücken und die Eingabe bestätigen. Fahren Sie mit der Taste [a] fort – bestätigen Sie Ihre Auswahl ein weiteres Mal mit der Eingabetaste. Nun legen Sie das gewünschte Passwort fest und bestätigen dieses, indem Sie es wiederholt eingeben. Beim nächsten Aufruf von rclone config fordert Sie die Open-Source-Anwendung automatisch auf, das Passwort einzugeben.

Datenmigration mit rclone: Am Beispiel von Google Drive

Die Möglichkeiten der Datenübertragung mit rclone sind vielfältig. Im Folgenden zeigen wir am Beispiel von Google Drive, wie Sie die Software für den Transfer von Dateien im Detail verwenden.

Als Betriebssystem wird Windows verwendet. Die Verwendung von rclone unter Linux oder macOS unterscheidet sich allerdings nicht von dem hier geschilderten Vorgehen. Es sind lediglich systemspezifische Eigenschaften wie beispielsweise bei der Angabe von Dateipfaden zu beachten.

Schritt 1: Remote-Verbindung zu Google Drive einrichten

Starten Sie die Eingabeaufforderung und führen Sie die rclone-Startdatei im entsprechenden Verzeichnis aus. Sobald die Anwendung läuft, rufen Sie das Konfigurationsmenü auf:

rclone configDrücken Sie [n], um eine neue Verbindung anzulegen. Als Namen (Kleinbuchstaben, keine Leerzeichen) verwenden wir in diesem Fall „gdrive“, um die Remote-Verbindung später gut zuordnen zu können. Die weiteren Schritte sehen wie folgt aus (Stand: Juli 2023):

- Als Storage-Typ geben Sie „18“ an. So verraten Sie rclone, dass es sich um den Cloud-Speicher von Google handelt (nicht zu verwechseln mit der Enterprise-Lösung Google Cloud Storage).

- Im nächsten Schritt können Sie eine individuelle Client-ID für die Verbindung zu Google Drive erstellen. Alternativ lassen Sie das Feld frei – und verwenden die nutzerübergreifende Standard-ID.

- Erstellen Sie, sofern erwünscht, eine geheime Phrase für den Schutz der Client-ID. Andernfalls lassen Sie den Eintrag frei.

- Für den vollen Zugriff auf die Dateien tragen Sie in der Zeile „scope“ den Wert „1“ ein.

- Wollen Sie anstelle des interaktiven Logins mit Dienstkonten arbeiten, müssen Sie im nächsten Schritt eine entsprechende JSON-Datei angeben. Auch dieses Feld ist optional: Lassen Sie es also frei, wenn Sie mit dem normalen Anmeldeverfahren zufrieden sind.

- Die erweiterten Optionen sind für den Nutzungszweck nicht erforderlich, weshalb Sie hier [n] (für „no“) eintippen.

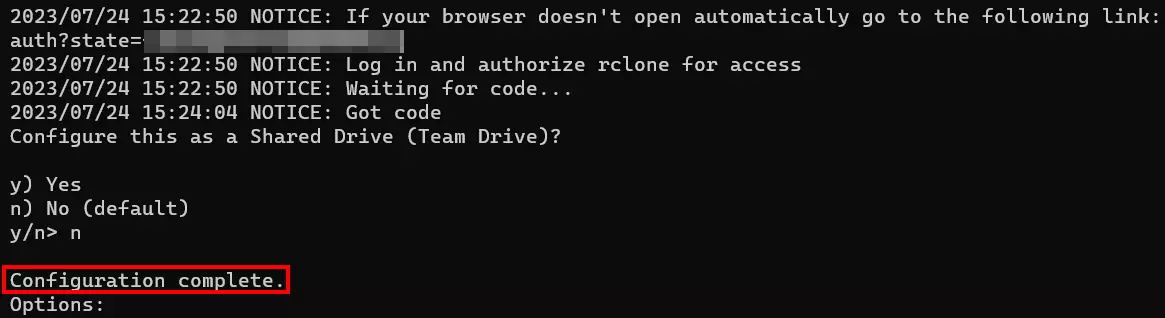

- Als nächstes bestätigen Sie mit [y], dass rclone automatisch auf einen Webbrowser zurückgreifen kann, um die Remote-Verbindung aufzubauen.

- Es öffnet sich automatisch ein Browserfenster, in dem Sie sich mit Ihrem Google-Konto anmelden, das mit dem gewünschten Google-Drive-Speicher verknüpft ist. Nach erfolgreicher Anmeldung und Bestätigung werden rclone und Google Drive verknüpft und Sie erhalten eine entsprechende Meldung.

- Verneinen Sie die Konfiguration als Mehrbenutzer-Speicher mit [n].

- Mit [y] bestätigen Sie zum Abschluss, dass Sie die eingerichtete Remote-Verbindung behalten wollen.

Schritt 2: Dateien und Ordner mit rclone auflisten

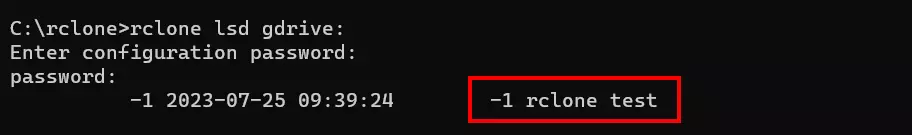

Nachdem Sie Google Drive und rclone verbunden haben, können Sie die Open-Source-Anwendung u. a. dazu verwenden, die aktuellen Ordner und Dateien in dem Cloud-Speicher von Google aufzulisten. Die Ordnerstruktur rufen Sie mit folgendem Kommando ab:

rclone lsd gdrive:

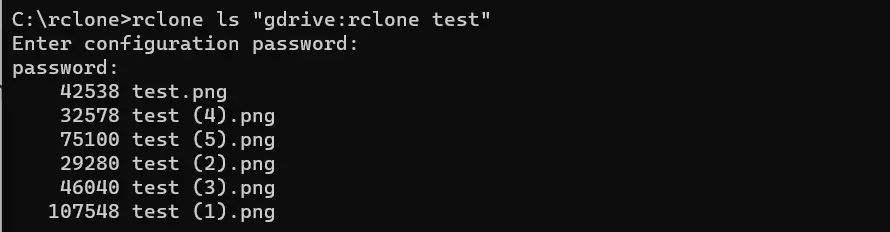

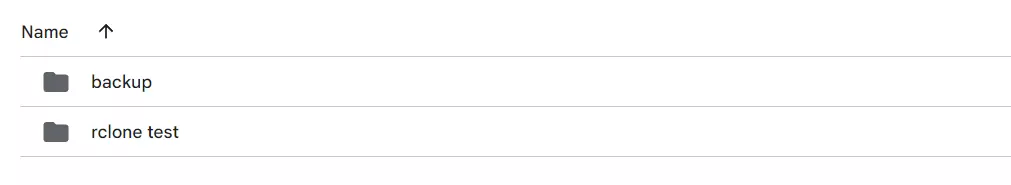

In unserem Fall befindet sich in dem Cloud-Speicher ein einzelner Ordner mit dem Namen rclone test. Den Inhalt dieses Ordners können Sie sich ebenfalls anzeigen lassen:

rclone ls "gdrive:rclone test"

Das hier verwendete ls-Kommando können Sie auch ohne konkrete Ordnerangabe verwenden, um auf einen Blick alle Dateien eines Cloud-Speichers aufzulisten. In unserem Fall wäre der passende Befehl für den gesamten Google-Drive-Inhalt folgender:

rclone ls gdrive:Schritt 3: Dateien mit rclone hochladen

Von dem Gerät, auf dem Sie rclone verwenden, können Sie nun außerdem jederzeit Dateien in Ihr verknüpftes Google-Drive-Konto hochladen. Auf diese Weise können Sie beispielsweise regelmäßig Backups eines Ordners bzw. Verzeichnisses erzeugen, in dem Sie wichtige Dokumente aufbewahren.

Exemplarisch wollen wir unser lokales Verzeichnis C:\data in Google Drive hochladen. Im Speicherdienst von Google sollen die Dateien in dem Ordner backup abgelegt werden. Um diesen Prozess mit rclone durchzuführen, benötigen wir den Befehl copy sowie die Angabe von Quell- und Zielort:

rclone copy C:\data gdrive:backupEin Blick in Google Drive zeigt uns, dass die Dateien erfolgreich hochgeladen wurden: Neben dem Ordner rclone test gibt es dort nun auch den neu generierten backup-Ordner.

Schritt 4: Dateien mit rclone herunterladen

Natürlich können Sie Dateien in der jeweiligen Remote-Umgebung mit rclone auch auf Ihr lokales Gerät herunterladen. Im Falle unseres Backups wäre dies beispielsweise dann sinnvoll, wenn Sie Ihre Dateien verloren oder aus Versehen gelöscht haben und wiederherstellen möchten.

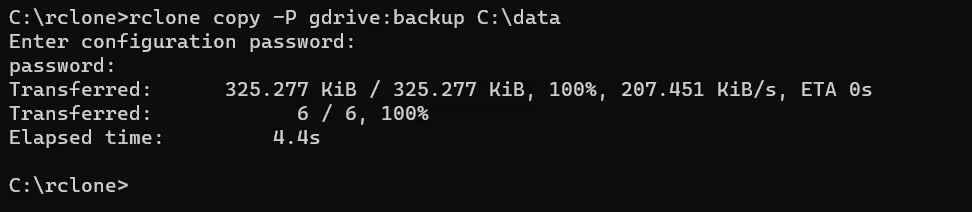

Quell- und Zielverzeichnis sind in diesem Fall genau umgekehrt, weshalb die Reihenfolge im benötigten rclone-Kommando anzupassen ist. Im Übrigen können Sie sich direkt in der Kommandozeile detaillierte Informationen zu dem Datentransfer anzeigen lassen, indem Sie den Parameter -P anhängen (auch beim Upload von Dateien möglich):

rclone copy -P gdrive:backup C:\data

Schritt 5: Dateien und Ordner mit rclone löschen

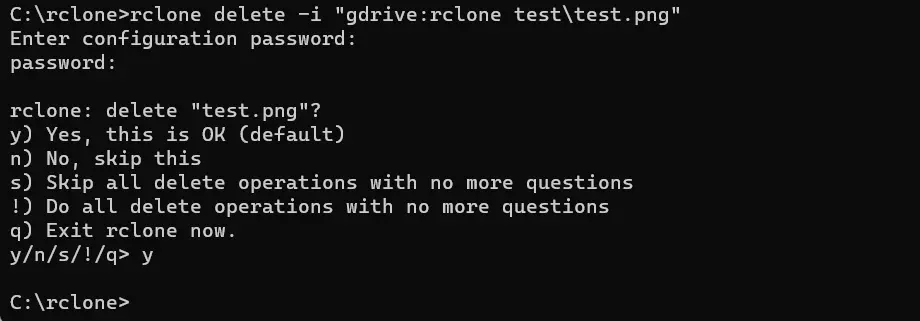

Mit rclone können Sie die Dateien und Ordner in einem Cloud-Speicher löschen, ohne sich hierfür extra in das Konto einloggen zu müssen. Wir löschen beispielhaft die Datei test.png, die in unserem initialen Ordner rclone test liegt (siehe Schritt 2). Für den Löschvorgang sind zum einen der Befehl delete und zum anderen die Angabe der Datei im Cloud Storage erforderlich. Es ist empfehlenswert, zusätzlich den Parameter -i zu verwenden, um eine Abfrage vor dem Löschen einzubauen:

rclone delete -i "gdrive:rclone test\test.png"Wenn Sie die Abfrage eingebaut haben, bestätigen Sie den Löschprozess mit [y].

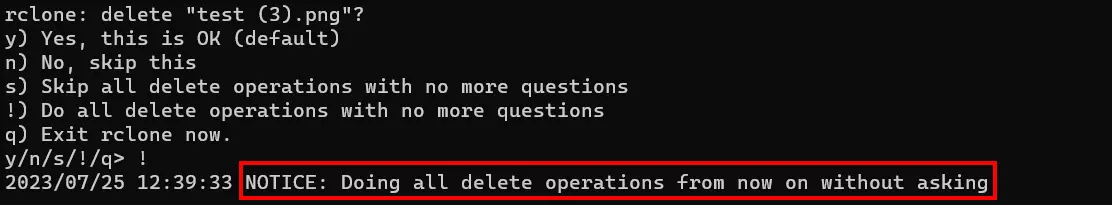

Um den gesamten Inhalt des Verzeichnisses bzw. Ordners zu löschen, lassen Sie die Angabe einer konkreten Datei weg und geben nur den Pfad des Ordners an:

rclone delete -i "gdrive:rclone test"Wenn Sie an dieser Stelle mit der Abfrage arbeiten, müssen Sie nun entweder das Löschen jeder Datei einzeln per [y] bestätigen oder Sie verwenden alternativ die Option [!], um alle Dateien ohne weitere Nachfrage aus dem jeweiligen Ordner im Cloud-Speicher zu entfernen.

Weitere Anwendungsgebiete für rclone

Wie bereits erwähnt, gehen die Möglichkeiten von rclone weit über den Transfer von Dateien von und zu lokalem Speicher hinaus. Nachfolgend haben wir einige weitere praktische Nutzungsszenarien des quelloffenen Tools zusammengefasst.

Datenmigration von Amazon S3 zu IONOS S3 Object Storage

Sie können in rclone nicht nur mehrere Remote-Verbindungen zu verschiedenen Cloud Storages einrichten, sondern auch Dateien zwischen den Cloud-Speichern austauschen. Wenn Sie also aktuell beispielsweise ein Amazon S3 Bucket für die Speicherung bestimmter Dateien nutzen, können Sie diese mit rclone jederzeit in wenigen Schritten in IONOS S3 Object Storage migrieren:

- Melden Sie sich im Konfigurationsmenü von rclone an.

- Richten Sie die Remote-Verbindungen für Amazon S3 und IONOS S3 Object Storage ein.

- Legen Sie Quell- (Amazon S3) und Zielverzeichnis (IONOS S3) für die Datenmigration fest.

- Nutzen Sie das rclone-Kommando

move, um Ihre Daten von Amazon zu IONOS zu migrieren.

Mehr zum move-Befehl in rclone erfahren Sie in der offziellen Dokumentation.

Dateidownload via HTTP(S)

Sie können rclone nutzen, um Dateien über das Protokoll HTTP bzw. HTTPS herunterzuladen.

Sie haben beispielsweise die Möglichkeit, die ISO-Datei für die Linux-Distribution ClearOS vom Mirror https://mirror1-frankfurt.clearos.com/clearos herunterzuladen. Zunächst richten Sie hierfür mit rclone config eine neue Remote-Verbindung mit den folgenden Eigenschaften ein:

- Name: ClearOS-mirror

- Type: HTTP

- URL: https://mirror1-frankfurt.clearos.com/clearos

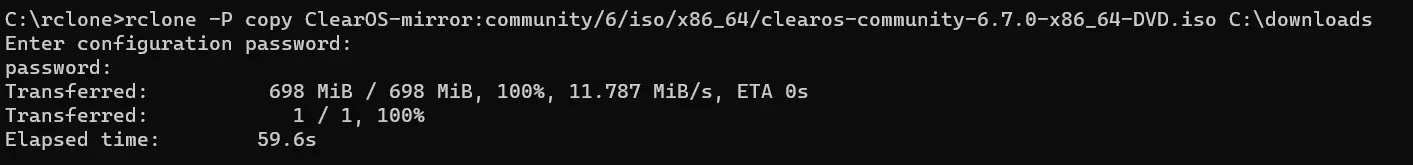

Nach der Einrichtung nutzen Sie folgende Befehlskette, um die ISO-Datei in das Verzeichnis C:\downloads herunterzuladen:

rclone -P copy ClearOS-mirror:community/6/iso/x86_64/clearos-community-6.7.0-x86_64-DVD.iso C:\downloads

Dateiupload via FTP(S)

Wenn Sie ein Web- bzw. Serververzeichnis besitzen, auf das Sie per FTP bzw. FTPS Dateien hochladen wollen, können Sie diesen Schritt ebenfalls mit rclone erledigen. Richten Sie zunächst eine neue Remote-Verbindung mit rclone config nach folgendem Muster ein:

- Name: mein-ftp

- Type: FTP

- Host: ftp.example.com (Ihre individuelle FTP-Adresse)

- User: Benutzername für die FTP-Anmeldung

- Port: Port-Nummer; freilassen, um den Standardport 21 zu wählen

- Password: Nutzen Sie hier die Möglichkeit, Ihr eigenes Passwort einzutragen

- TLS: Optionale TLS-Verschlüsselung; freilassen, falls nicht gewünscht

Wollen Sie nun zum Beispiel die zuvor heruntergeladene ISO-Datei in den Ordner iso-images auf Ihrem FTP-Webspace übertragen, führen Sie einfach das folgende rclone-Kommando aus:

rclone copy C:\downloads\clearos-community-6.7.0-x86_64-DVD mein-ftp:iso-images/